创新背景

随着人工智能的发展,人机交互越来越频繁,一些交互式AI产品故意开发儿童图书机器人的角色,寻求使机器人更加逼真的技术,并致力于使人与虚拟机器人的交互更加自然或“无缝”,但从伦理学的角度而言,这并不意味着绝对有利。

创新过程

大多数现代机器人伦理学都指出,机器不应该误导人类认识它们的身份。类似于人类的机器人可能包含其身份的正式或细则披露,但如果整体效果栩栩如生,那么这些免责声明是否具有任何实际效果是值得怀疑的。

与隐私政策一样,大多数人可能不阅读或理解它们,并且它们可能不是为不同的用户(如残疾消费者或老年人)量身定制的。

AI“误导”的影响

从道德的角度来看,人工智能误导人们几乎总是有问题的,因为它涉及将他们视为达到另一个人的目的。在AI将自己表示为人类的背景下,风险在于被误导的人会泄露更多信息,并且加深对机器人的信任,这可能意味着人机关系中会产生更大程度的“摩擦”。

人们可能都知道数字助理不是真的。使其同类产品的声音真正和人声一样自然需要付出很多努力。这显然在某种程度上是成功的,因为数字助力Alexa得到了求婚,但它礼貌地拒绝了。Alexa相关的大部分广告都在以人形的样子调侃它。

人们仍然对人工智能可能对人类信任产生的影响知之甚少。有人担心人工智能设备的友好性与一个人对其设置、控制和操作方式缺乏了解相结合,可能会让一些消费者泄露出比他们应该透露的更多的信息。

隐私担忧调查

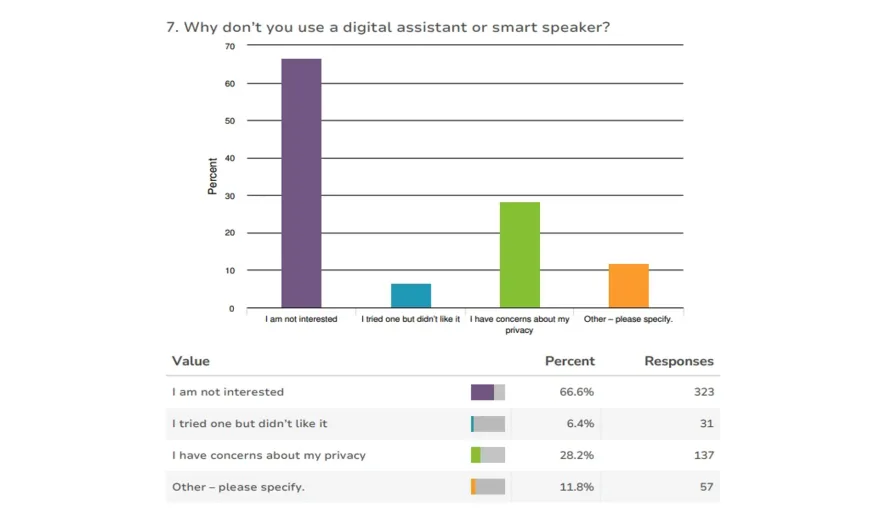

当涉及到数据隐私和网络安全时,这种担忧的存在极有必要。如果用户不了解设备的限制,他们可能根本无法采取保护自己所需的预防措施。研究对1000名澳大利亚人进行了一项调查,了解他们对数字助理的使用以及他们在使用这些设备时有(或没有)的担忧。

超过一半的受访者表示经常或偶尔使用数字助理或智能扬声器,隐私问题对消费者来说是一个现实问题。他们担心AI设备偷听对话,记录和收集有关用户的数据,而他们不知道,也不知道录音,数据或其他信息将存储在哪里或多长时间或用于什么目的。

在表示不使用数字助理的人中,只有不到30%的人表示,其中一个原因是担心他们的隐私。在偶尔或经常使用数字设备的受访者中,近三分之一的人对此表示适度关注,近四分之一的受访者非常或非常担心。

超过40%的用户担心无法控制他们的录音或其他信息发生了什么。使用数字设备的受访受访者中有65.5%表示他们不知道是否可以更改隐私设置,另有11.1%的人表示他们无法更改这些设置。

人工智能的隐私风险

对这些隐私问题的担心强调不仅需要法律给予有效的保护制成,人工智能设备的设计中也需要注意这些问题。目前AI进入类人对话的效果也可能用于提醒用户在私人对话期间关闭设备或更新其软件和密码的功能中。

一个不太自然的界面可能会提醒用户他们实际上是在处理机器。任何设计更改都应与用户自己协商,以确保满足他们的信息和消费者需求。在这种情况下,未来用户和数字助理之间的信任减少可能是一件好事。

创新关键点

从人类对AI的信任以及误导性后果出发,探究数字时代的隐私风险问题和人工智能伦理学,表明用户对数字设备的信任应该适度。

智能推荐

社会管理学创新思维 | 模块化案例系列研究帮助重视计算的社会与道德责任

2022-07-25利用模块化案例系列的研究帮助计算技术相关人才在培养过程中了解计算机发展带来的社会、法律、道德影响。

涉及学科涉及领域研究方向医学创新思维 | 科技深入人类自身研究后需要重视科技伦理

2022-06-29科技伦理拓展覆盖领域范围,促进人文和科技共同发展。

涉及学科涉及领域研究方向管理学创新思维 | 未来比你想象的要快得多(2)

2022-07-10主讲人:Peter Diamandis

涉及学科涉及领域研究方向管理学创新思维 | 未来比你想象的要快得多(1)

2022-07-10主讲人:Peter Diamandis

涉及学科涉及领域研究方向